Sqoop 教程:什么是 Apache Sqoop?架构和示例

Hadoop中的SQOOP是什么?

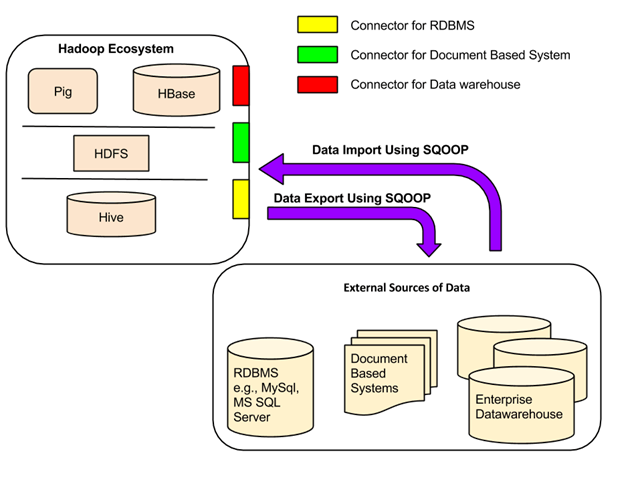

Apache SQOOP(SQL-to-Hadoop)是一个旨在支持从结构化数据存储(如关系型数据库、企业数据仓库和NoSQL系统)批量导入和导出数据到HDFS的工具。它是一个基于连接器架构的数据迁移工具,支持插件以提供与新的外部系统的连接能力。

Hadoop Sqoop的一个用例是,一家企业运行夜间Sqoop导入,将数据从生产事务RDBMS加载到Hive数据仓库中进行进一步分析。

在本文的Apache Sqoop教程中,接下来我们将学习Apache Sqoop的架构。

Sqoop架构

所有现有的数据库管理系统都是根据SQL标准设计的。然而,每种DBMS在方言方面都存在一定程度的差异。因此,当涉及跨系统的数据传输时,这种差异会带来挑战。Sqoop连接器是帮助克服这些挑战的组件。

在Sqoop Hadoop与外部存储系统之间的数据传输,得益于Sqoop的连接器。

Sqoop拥有用于处理各种流行关系型数据库的连接器,包括MySQL、PostgreSQL、Oracle、SQL Server和DB2。其中每个连接器都知道如何与其关联的DBMS进行交互。还有一个通用的JDBC连接器,用于连接支持Java JDBC协议的任何数据库。此外,Sqoop大数据还提供了优化的MySQL和PostgreSQL连接器,它们使用特定数据库的API来高效地执行批量传输。

除此之外,大数据中的Sqoop还有各种第三方连接器,用于各种数据存储,从企业数据仓库(包括Netezza、Teradata和Oracle)到NoSQL存储(如Couchbase)。但是,这些连接器不包含在Sqoop捆绑包中;它们需要单独下载,并可以轻松添加到现有的Sqoop安装中。

我们为什么需要Sqoop?

使用Hadoop进行分析处理需要将海量数据从不同来源加载到Hadoop集群中。这个将数据批量加载到Hadoop,从异构源然后进行处理的过程,伴随着一系列挑战。维护和确保数据一致性以及确保资源的有效利用,是在选择正确的数据加载方法之前需要考虑的一些因素。

主要问题

1. 使用脚本加载数据

使用脚本加载数据的传统方法不适用于将数据批量加载到Hadoop;这种方法效率低下且非常耗时。

2. Map-Reduce应用程序直接访问外部数据

为Map-Reduce应用程序提供对外部系统数据的直接访问(无需加载到Hadoop)会使这些应用程序复杂化。因此,这种方法是不可行的。

3. 除了能够处理海量数据外,Hadoop还能处理多种不同形式的数据。因此,为了将这种异构数据加载到Hadoop中,开发了不同的工具。Sqoop和Flume是两个这样的数据加载工具。

在本文的Sqoop教程(含示例)中,接下来我们将学习Sqoop、Flume和HDFS之间的区别。

Sqoop与Flume与HDFS在Hadoop中的对比

| Sqoop | Flume | HDFS |

|---|---|---|

| Sqoop用于从RDBMS等结构化数据源导入数据。 | Flume用于将流式数据批量传输到HDFS。 | HDFS是Hadoop生态系统用于存储数据的一种分布式文件系统。 |

| Sqoop具有基于连接器的架构。连接器知道如何连接到相应的数据源并获取数据。 | Flume具有基于代理的架构。这里编写一段代码(称为“代理”),负责获取数据。 | HDFS具有一种分布式架构,数据分布在多个数据节点上。 |

| HDFS是Sqoop导入数据的目标。 | 数据通过零个或多个通道流向HDFS。 | HDFS是数据的最终存储目的地。 |

| Sqoop数据加载不是事件驱动的。 | Flume数据加载可以由事件驱动。 | HDFS只是存储提供给它的数据。 |

| 为了从结构化数据源导入数据,必须仅使用Sqoop命令,因为它的连接器知道如何与结构化数据源进行交互并从中获取数据。 | 为了加载流式数据,例如Twitter上生成的推文或Web服务器的日志文件,应使用Flume。Flume代理专为获取流式数据而构建。 | HDFS有自己的内置Shell命令来存储数据。HDFS无法导入流式数据。 |