PyTorch迁移学习教程及示例

什么是迁移学习?

迁移学习是一种利用已训练模型来解决另一个相关任务的技术。它是一种机器学习研究方法,可以存储在解决特定问题时获得的知识,并利用相同的知识来解决另一个不同但相关的任务。通过重用先前学习任务中收集的信息来提高效率。

为了减少训练时间,通常会使用其他网络的模型权重,因为训练网络模型需要大量数据。为了减少训练时间,您可以使用其他网络及其权重,并修改最后一层来解决我们的问题。优点是可以使用较小的数据集来训练最后一层。

接下来,在本 PyTorch 迁移学习教程中,我们将学习如何使用 PyTorch 进行迁移学习。

加载数据集

在开始使用 PyTorch 迁移学习之前,您需要了解您将要使用的数据集。在此迁移学习 PyTorch 示例中,您将从近 700 张图像中对“异形”和“捕食者”进行分类。对于这项技术,您实际上不需要大量数据来进行训练。您可以从Kaggle:异形 vs. 捕食者下载数据集。

如何使用迁移学习?

以下是使用 PyTorch 进行深度学习迁移学习的步骤:

步骤 1) 加载数据

第一步是加载数据并对图像进行一些转换,使其符合网络要求。

您将使用 torchvision.dataset 从文件夹加载数据。该模块将遍历文件夹以将数据分为训练集和验证集。转换过程将裁剪中心图像,执行水平翻转,标准化,最后使用深度学习将其转换为张量。

from __future__ import print_function, division

import os

import time

import torch

import torchvision

from torchvision import datasets, models, transforms

import torch.optim as optim

import numpy as np

import matplotlib.pyplot as plt

data_dir = "alien_pred"

input_shape = 224

mean = [0.5, 0.5, 0.5]

std = [0.5, 0.5, 0.5]

#data transformation

data_transforms = {

'train': transforms.Compose([

transforms.CenterCrop(input_shape),

transforms.ToTensor(),

transforms.Normalize(mean, std)

]),

'validation': transforms.Compose([

transforms.CenterCrop(input_shape),

transforms.ToTensor(),

transforms.Normalize(mean, std)

]),

}

image_datasets = {

x: datasets.ImageFolder(

os.path.join(data_dir, x),

transform=data_transforms[x]

)

for x in ['train', 'validation']

}

dataloaders = {

x: torch.utils.data.DataLoader(

image_datasets[x], batch_size=32,

shuffle=True, num_workers=4

)

for x in ['train', 'validation']

}

dataset_sizes = {x: len(image_datasets[x]) for x in ['train', 'validation']}

print(dataset_sizes)

class_names = image_datasets['train'].classes

device = torch.device("cuda:0" if torch.cuda.is_available() else "cpu")

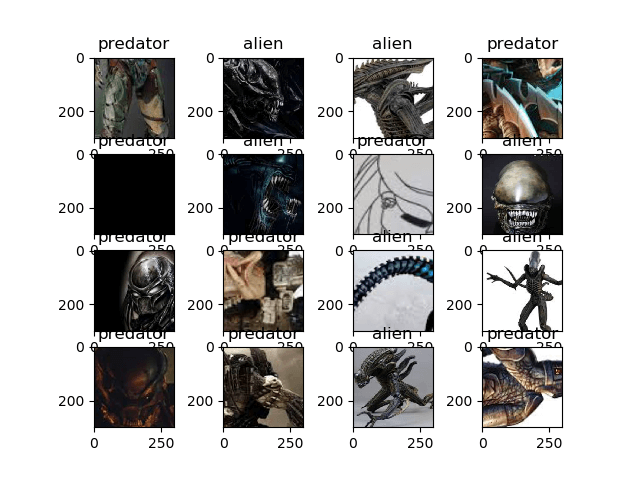

让我们可视化 PyTorch 迁移学习的数据集。可视化过程将从训练数据加载器和标签中获取下一批图像,并使用 matplot 显示它们。

images, labels = next(iter(dataloaders['train'])) rows = 4 columns = 4 fig=plt.figure() for i in range(16): fig.add_subplot(rows, columns, i+1) plt.title(class_names[labels[i]]) img = images[i].numpy().transpose((1, 2, 0)) img = std * img + mean plt.imshow(img) plt.show()

步骤 2) 定义模型

在此深度学习过程中,您将使用 torchvision 模块中的 ResNet18。

您将使用 torchvision.models 加载 resnet18,并将预训练权重设置为 True。之后,您将冻结层,以便这些层不可训练。您还将修改最后一层,使用一个线性层以适应我们的需求,即 2 个类别。您还可以使用 CrossEntropyLoss 作为多类别损失函数,对于优化器,您将使用 SGD,学习率为 0.0001,动量为 0.9,如下面的 PyTorch 迁移学习示例所示。

## Load the model based on VGG19 vgg_based = torchvision.models.vgg19(pretrained=True) ## freeze the layers for param in vgg_based.parameters(): param.requires_grad = False # Modify the last layer number_features = vgg_based.classifier[6].in_features features = list(vgg_based.classifier.children())[:-1] # Remove last layer features.extend([torch.nn.Linear(number_features, len(class_names))]) vgg_based.classifier = torch.nn.Sequential(*features) vgg_based = vgg_based.to(device) print(vgg_based) criterion = torch.nn.CrossEntropyLoss() optimizer_ft = optim.SGD(vgg_based.parameters(), lr=0.001, momentum=0.9)

输出模型结构

VGG( (features): Sequential( (0): Conv2d(3, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (1): ReLU(inplace) (2): Conv2d(64, 64, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (3): ReLU(inplace) (4): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False) (5): Conv2d(64, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (6): ReLU(inplace) (7): Conv2d(128, 128, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (8): ReLU(inplace) (9): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False) (10): Conv2d(128, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (11): ReLU(inplace) (12): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (13): ReLU(inplace) (14): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (15): ReLU(inplace) (16): Conv2d(256, 256, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (17): ReLU(inplace) (18): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False) (19): Conv2d(256, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (20): ReLU(inplace) (21): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (22): ReLU(inplace) (23): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (24): ReLU(inplace) (25): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (26): ReLU(inplace) (27): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False) (28): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (29): ReLU(inplace) (30): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (31): ReLU(inplace) (32): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (33): ReLU(inplace) (34): Conv2d(512, 512, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1)) (35): ReLU(inplace) (36): MaxPool2d(kernel_size=2, stride=2, padding=0, dilation=1, ceil_mode=False) ) (classifier): Sequential( (0): Linear(in_features=25088, out_features=4096, bias=True) (1): ReLU(inplace) (2): Dropout(p=0.5) (3): Linear(in_features=4096, out_features=4096, bias=True) (4): ReLU(inplace) (5): Dropout(p=0.5) (6): Linear(in_features=4096, out_features=2, bias=True) ) )

步骤 3) 训练和测试模型

我们将使用迁移学习PyTorch 教程中的一些函数来帮助我们训练和评估模型。

def train_model(model, criterion, optimizer, num_epochs=25):

since = time.time()

for epoch in range(num_epochs):

print('Epoch {}/{}'.format(epoch, num_epochs - 1))

print('-' * 10)

#set model to trainable

# model.train()

train_loss = 0

# Iterate over data.

for i, data in enumerate(dataloaders['train']):

inputs , labels = data

inputs = inputs.to(device)

labels = labels.to(device)

optimizer.zero_grad()

with torch.set_grad_enabled(True):

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

train_loss += loss.item() * inputs.size(0)

print('{} Loss: {:.4f}'.format(

'train', train_loss / dataset_sizes['train']))

time_elapsed = time.time() - since

print('Training complete in {:.0f}m {:.0f}s'.format(

time_elapsed // 60, time_elapsed % 60))

return model

def visualize_model(model, num_images=6):

was_training = model.training

model.eval()

images_so_far = 0

fig = plt.figure()

with torch.no_grad():

for i, (inputs, labels) in enumerate(dataloaders['validation']):

inputs = inputs.to(device)

labels = labels.to(device)

outputs = model(inputs)

_, preds = torch.max(outputs, 1)

for j in range(inputs.size()[0]):

images_so_far += 1

ax = plt.subplot(num_images//2, 2, images_so_far)

ax.axis('off')

ax.set_title('predicted: {} truth: {}'.format(class_names[preds[j]], class_names[labels[j]]))

img = inputs.cpu().data[j].numpy().transpose((1, 2, 0))

img = std * img + mean

ax.imshow(img)

if images_so_far == num_images:

model.train(mode=was_training)

return

model.train(mode=was_training)

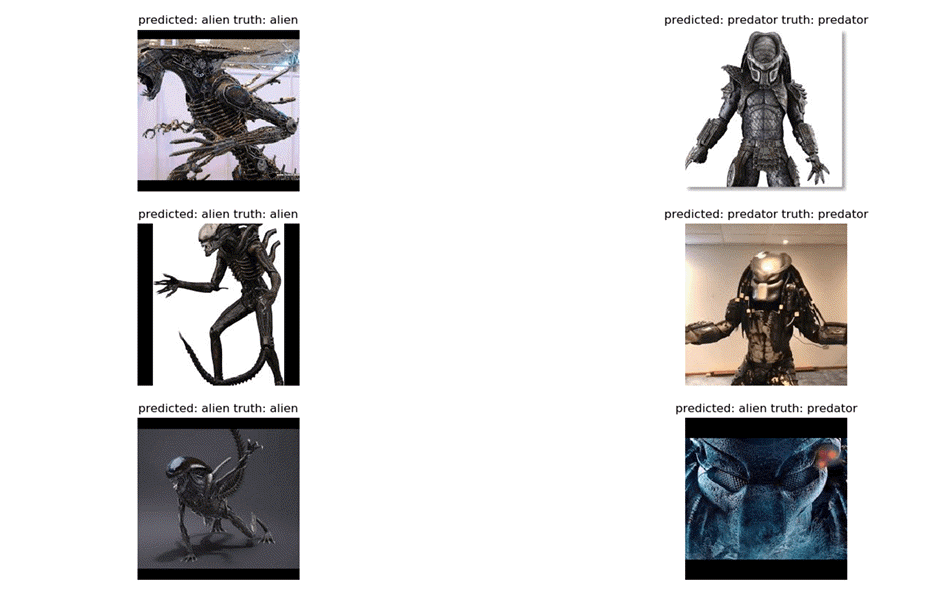

最后,在此 PyTorch 迁移学习示例中,让我们开始训练过程,将 epoch 数设置为 25,并在训练过程后进行评估。在每个训练步骤中,模型将接收输入并预测输出。之后,预测输出将被传递到 criterion 以计算损失。然后,损失将执行反向传播计算梯度,最后通过 autograd 计算权重并优化参数。

在可视化模型时,将使用一批图像来测试训练好的网络,以预测标签。然后将借助 matplotlib 进行可视化。

vgg_based = train_model(vgg_based, criterion, optimizer_ft, num_epochs=25) visualize_model(vgg_based) plt.show()

步骤 4) 结果

最终结果是您达到了 92% 的准确率。

Epoch 23/24 ---------- train Loss: 0.0044 train Loss: 0.0078 train Loss: 0.0141 train Loss: 0.0221 train Loss: 0.0306 train Loss: 0.0336 train Loss: 0.0442 train Loss: 0.0482 train Loss: 0.0557 train Loss: 0.0643 train Loss: 0.0763 train Loss: 0.0779 train Loss: 0.0843 train Loss: 0.0910 train Loss: 0.0990 train Loss: 0.1063 train Loss: 0.1133 train Loss: 0.1220 train Loss: 0.1344 train Loss: 0.1382 train Loss: 0.1429 train Loss: 0.1500 Epoch 24/24 ---------- train Loss: 0.0076 train Loss: 0.0115 train Loss: 0.0185 train Loss: 0.0277 train Loss: 0.0345 train Loss: 0.0420 train Loss: 0.0450 train Loss: 0.0490 train Loss: 0.0644 train Loss: 0.0755 train Loss: 0.0813 train Loss: 0.0868 train Loss: 0.0916 train Loss: 0.0980 train Loss: 0.1008 train Loss: 0.1101 train Loss: 0.1176 train Loss: 0.1282 train Loss: 0.1323 train Loss: 0.1397 train Loss: 0.1436 train Loss: 0.1467 Training complete in 2m 47s

然后,我们的模型输出将通过 matplot 可视化如下:

摘要

那么,让我们总结一下!第一个因素是 PyTorch 是一个不断发展的深度学习框架,适合初学者或研究目的。它提供高计算时间、动态图、GPU 支持,并且完全用Python编写。您可以轻松定义自己的网络模块,并轻松地进行训练过程。显然,PyTorch 非常适合初学者探索深度学习,对于专业研究人员来说,它也非常有用,因为计算时间更快,并且 autograd 函数也非常有助于动态图。